Rédaction

Date

Comment rendre les jeux vidéo plus inclusifs pour les personnes sourdes?

Gaëlle Thibaudat, étudiante à la maîtrise en informatique option jeu vidéo à l’UQAC et stagiaire au CDRIN, a relevé un défi majeur d’accessibilité dans l’univers du jeu vidéo: elle a développé une API open-source de reconnaissance de la langue des signes en temps réel intégrable aux moteurs de jeu. À la croisée de la vision par ordinateur, de l’intelligence artificielle et de l’inclusivité, ce projet innovant sur un sujet méconnu du grand public et de l’industrie ouvre la voie à des expériences vidéoludiques plus équitables et immersives.

Dans cet article, Gaëlle partage son parcours unique, marqué par son expérience personnelle de la surdité. Elle y dévoile les défis techniques, linguistiques et humains qu’elle a surmontés avec grande détermination, ainsi que les précieux apprentissages issus de cette recherche qui enrichit tant l’aspect culturel que technologique des jeux vidéo.

Une idée née d’un vécu

En tant que personne sourde utilisant la langue des signes française (LSF) et québécoise (LSQ), j’ai souvent constaté combien les environnements numériques, notamment les jeux vidéo, restaient peu accessibles.

Lorsqu’on m’a donné carte blanche pour proposer un sujet de stage, l’idée m’est venue naturellement: pourquoi ne pas créer une passerelle technologique entre la langue des signes et le jeu vidéo?

Je voulais que ce projet réponde à des besoins concrets, tout en valorisant la culture sourde. J’ai donc proposé de développer une API de reconnaissance de la langue des signes — un outil qui permettrait aux personnes sourdes d’interagir autrement avec les jeux, et pourquoi pas, de s’y exprimer en langue des signes.

Une API pour la langue des signes dans les jeux vidéo

Mon projet visait à concevoir une API capable de détecter et d’interpréter des séquences gestuelles issues de la langue des signes. Cette API pourrait ensuite être intégrée dans des moteurs de jeux populaires comme Unity ou Unreal Engine, afin de permettre une interaction plus naturelle, fluide et accessible.

Je devais également développer une base de données de signes adaptée, de tester et valider le modèle avec des expert.es et des studios de jeux vidéo, puis de documenter le projet en open source pour faciliter son adoption et évolution par d’autres développeurs et développeuses.

L’idée, à terme, est de permettre aux joueurs sourds et joueuses sourdes de signer pour jouer — de traduire des gestes en actions dans le jeu ou d’afficher des traductions visuelles adaptées. Et surtout, de créer des expériences vidéoludiques plus inclusives, dans lesquelles la langue des signes aurait toute sa place.

De la recherche à la programmation: les étapes du projet

La première étape a été de réaliser une veille technologique approfondie. J’ai analysé les solutions existantes, comparé des modèles d’intelligence artificielle, étudié les bases de données disponibles et rédigé un cahier des charges technique.

Cette phase d’analyse m’a permise de comparer différentes architectures de réseaux de neurones pertinentes pour traiter des données gestuelles complexes (CNN, RNN, LSTM, Transformers), ainsi que les frameworks adaptés au prototypage d’un système de vision par ordinateur (TensorFlow, PyTorch, Mediapipe, etc.). J’ai également exploré l’état de l’art concernant les bases de données en langue des signes et les API open source existantes, en constatant notamment l’absence de corpus en langue des signes québécoise (LSQ). Faute de mieux, j’ai retenu MediaPI-RGB, une base de référence en langue des signes française (LSF).

Sur la base de cette veille et de l’état de l’art, j’ai rédigé une charge de projet détaillé définissant les choix technologiques, les critères de performance visés, les contraintes d’accessibilité à prendre en compte, ainsi que les étapes clés menant à un prototype fonctionnel, open source et évolutif

J’ai choisi de m’appuyer sur des technologies comme Mediapipe et TensorFlow, en combinant des réseaux de neurones CNN (pour l’analyse spatiale) et LSTM (pour la dimension temporelle des gestes). J’ai utilisé la base de données MediaPI-RGB, composée de vidéos de langue des signes française (LSF), en l’absence d’un corpus accessible en LSQ.

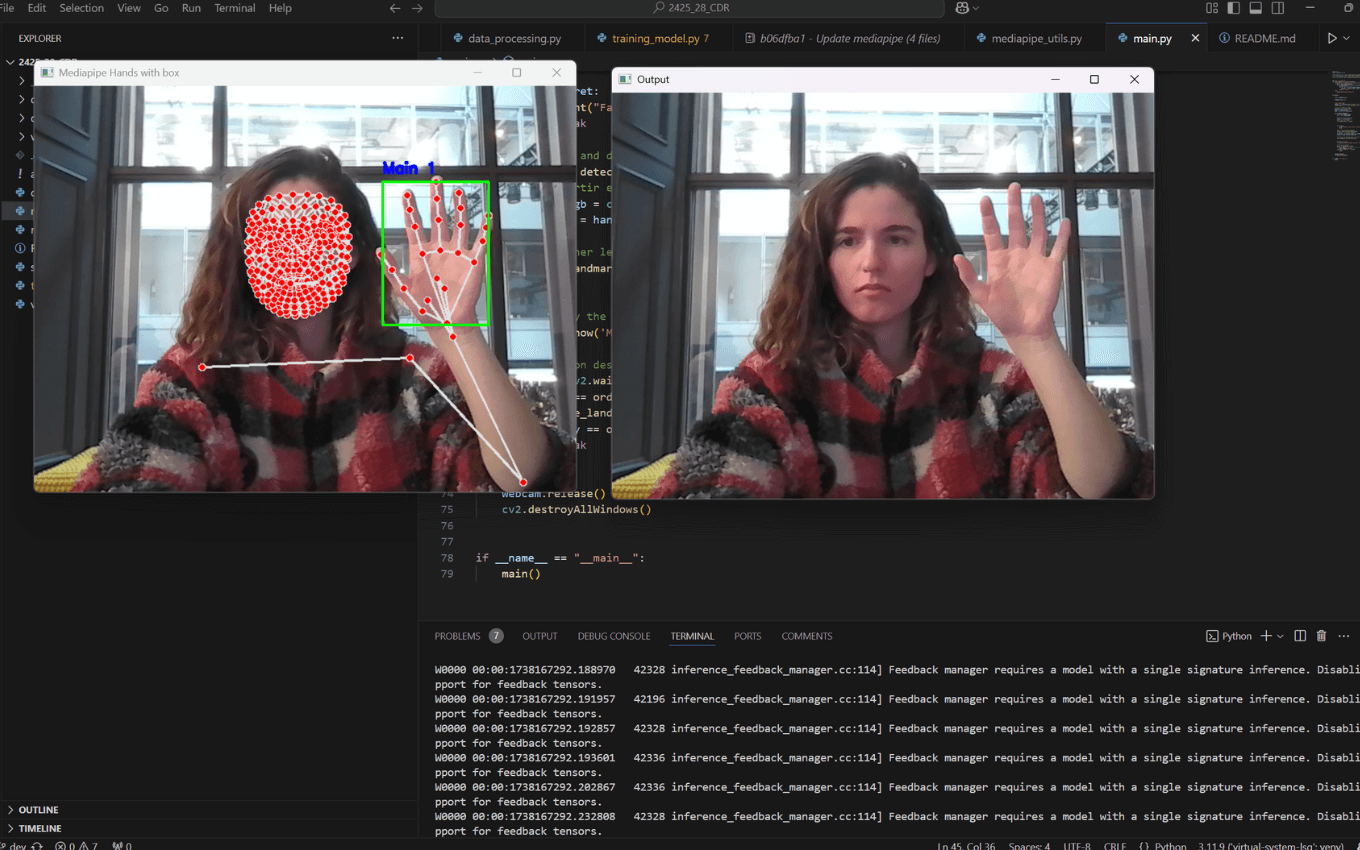

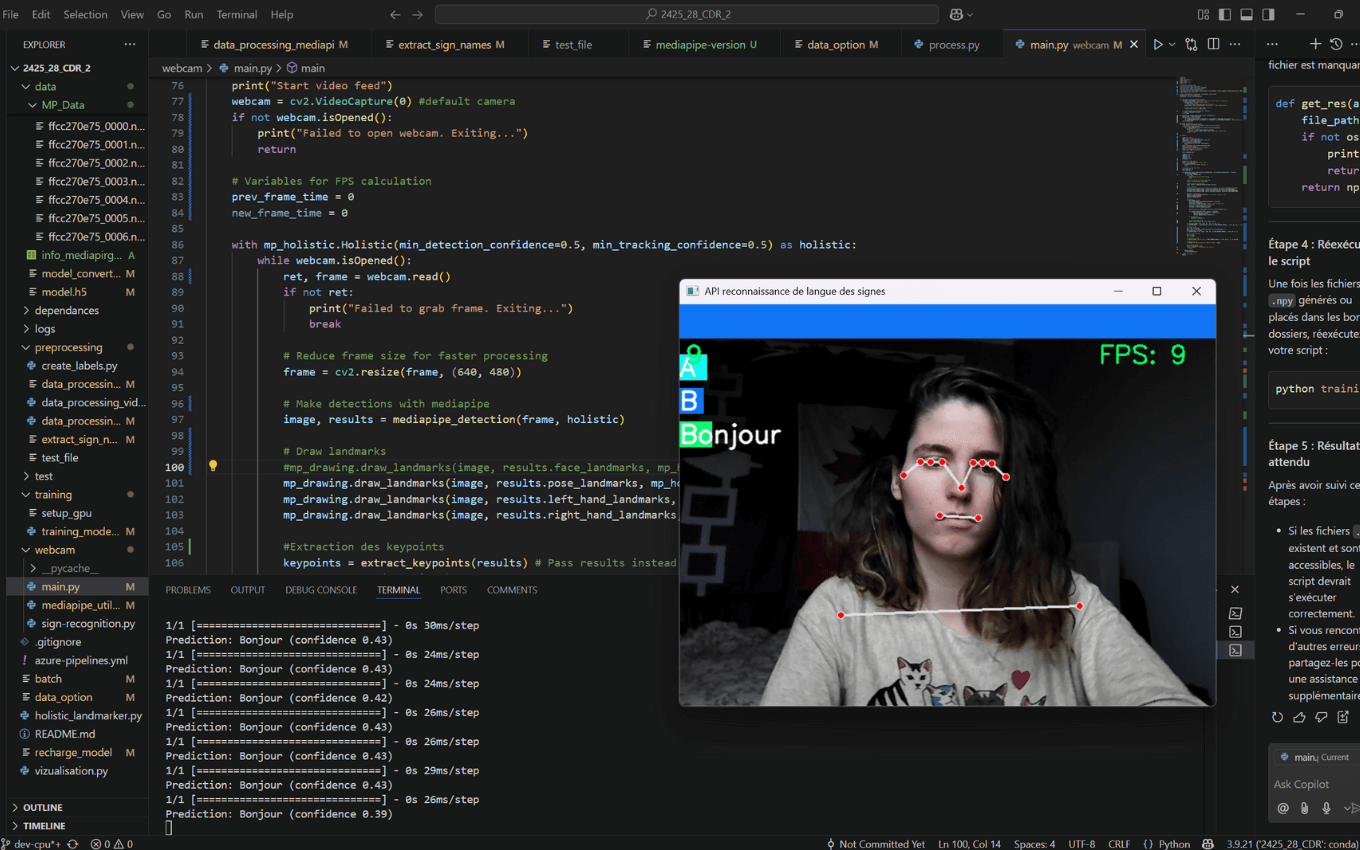

J’ai conçu un prototype de l’API capable de reconnaître certains signes de manière simplifiée. Pour cela, j’ai extrait les keypoints (points-clés du corps, des mains et du visage), normalisé les données, entraîné un modèle et développé une interface d’affichage en temps réel. Le tout a été documenté et structuré pour une mise en open source.

Les étapes en bref

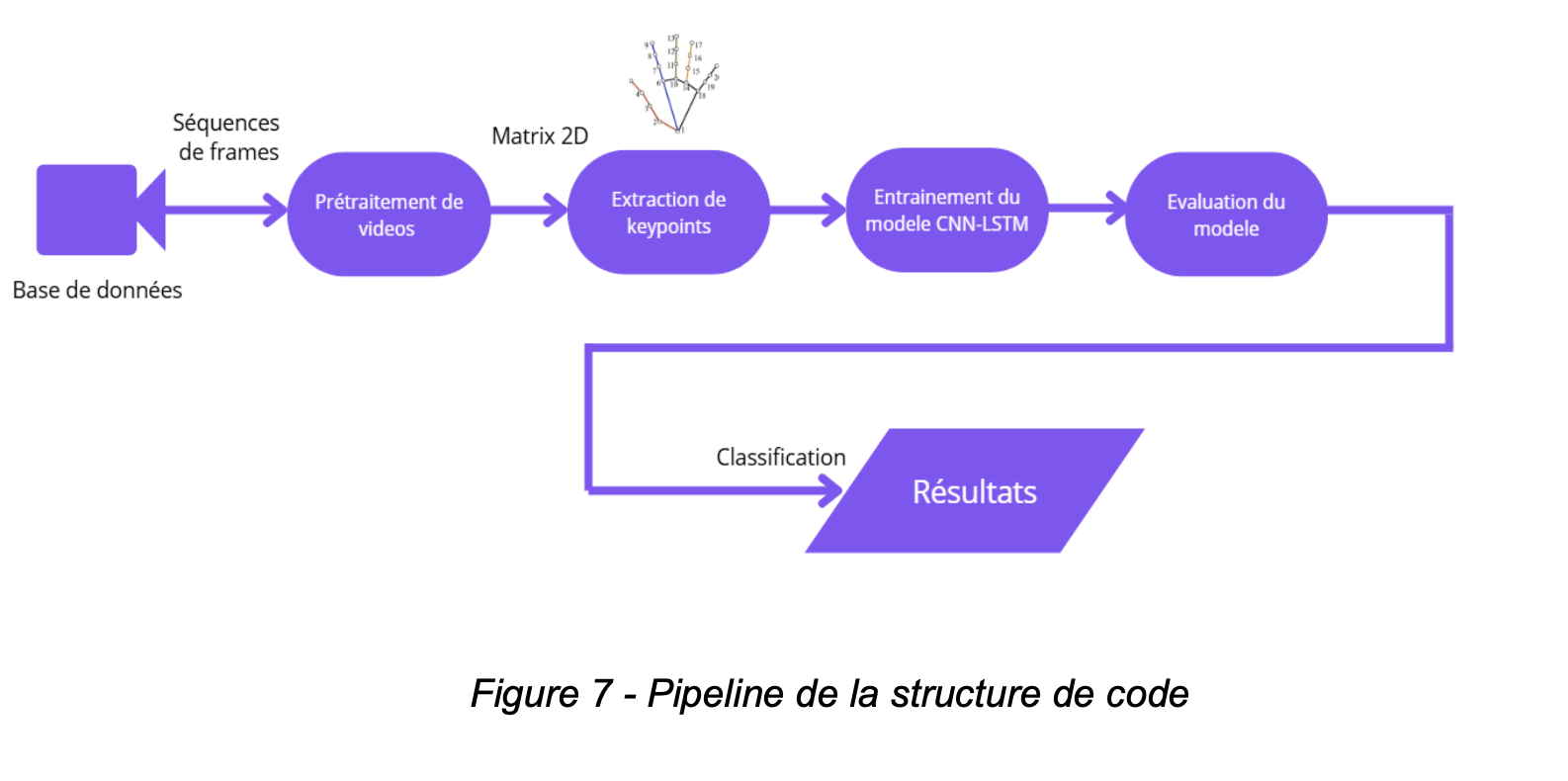

- Prétraitement de vidéos: Les vidéos issues de la base de données sont segmentées en séquences d’images afin de permettre une analyse frame par frame.

- Extraction des points-clés (keypoints): Chaque frame est traité à l’aide de Mediapipe pour extraire les coordonnées des points-clés du corps, des mains et du visage.

- Entraînement du modèle CNN-LSTM: Les séquences de points-clés sont utilisées pour entraîner un modèle combinant un réseau de neurones convolutif (CNN) pour l’analyse spatiale et un réseau LSTM pour la modélisation temporelle des signes.

- Évaluation du modèle: Les performances du modèle sont évaluées à l’aide d’un jeu de données de test afin de valider sa capacité de généralisation.

- Reconnaissance de langue des signes en temps réel: Une interface d’affichage permet la classification des signes reconnus en temps réel, et l’affichage du taux de confiance, et de frames offrant ainsi une démonstration fonctionnelle de l’API

Les défis que j’ai rencontrés… et les solutions que j’ai trouvées

Ce projet m’a confrontée à plusieurs obstacles. D’abord, la langue des signes est très visuelle, dynamique et contextuelle: chaque variante (LSQ, LSF, ASL…) a sa propre grammaire, et les signes peuvent varier d’une personne à l’autre. Cela rend la reconnaissance automatique complexe.

Ensuite, sur le plan technique, j’ai dû apprendre à maîtriser de nouveaux outils (Conda, GitHub, Azure DevOps), à structurer mon code de façon modulaire, à optimiser les performances du modèle, à gérer des environnements GPU/CPU parfois instables.

J’ai aussi rencontré des limites liées aux données: peu de bases de données sont disponibles pour la LSQ. J’ai donc dû m’adapter, tout en préparant le terrain pour une future collecte de données dédiée.

Mais ces défis m’ont beaucoup appris. Grâce à l’accompagnement du CDRIN, aux échanges réguliers avec mon tuteur et aux formations complémentaires que j’ai suivies, j’ai pu progresser en vision par ordinateur, en intelligence artificielle, et en gestion de projet.

Une démarche inclusive et collaborative

Dès le départ, j’ai voulu que ce projet s’inscrive dans une démarche éthique et inclusive. J’ai travaillé avec des interprètes LSQ, j’ai échangé avec des membres de la communauté sourde, et j’ai conçu une documentation accessible pour que d’autres développeurs et développeuses puissent s’en inspirer.

J’ai aussi misé sur l’open source, parce que je crois que le partage des connaissances est essentiel pour faire avancer l’accessibilité. Ce projet n’a pas vocation à rester un prototype isolé: il est pensé pour être repris, amélioré, adapté.

Ce que j’ai appris… et ce que je retiens

Ce stage a été bien plus qu’un exercice académique. Il m’a permis de me sentir utile, de contribuer concrètement à un enjeu qui me tient à cœur, et de me projeter dans un avenir professionnel où l’accessibilité et la technologie vont de pair.

J’ai appris à travailler en autonomie, à collaborer à distance, à demander de l’aide quand il le fallait, à structurer ma pensée et à oser proposer mes idées. J’ai aussi pris conscience que mon expérience de la surdité pouvait devenir une force, une compétence en soi.

Je rêve désormais de créer des expériences numériques immersives accessibles en langue des signes, que ce soit dans le jeu vidéo, la réalité virtuelle ou d’autres formes de narration interactive.

Et maintenant?

Le prototype fonctionne, mais il reste du travail. Il faudra affiner les modèles, améliorer la précision, tester l’API avec des studios, intégrer l’outil dans Unity et Unreal, et pourquoi pas, créer un avatar 3D qui signe en temps réel.

Mais ce que je retiens surtout, c’est que ce projet est un pas de plus vers une accessibilité concrète et ambitieuse dans le jeu vidéo. Une preuve que l’innovation peut — et doit — servir l’inclusion.

Merci au CDRIN de m’avoir fait confiance, et à toutes les personnes qui m’ont accompagnée dans cette belle aventure.

« Il est essentiel d’impliquer les personnes concernées pour mieux comprendre leurs besoins et construire des solutions adaptées. C’est là que naît l’innovation qui fait sens. » – Gaëlle Thibaudat